1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

| package crawl

import (

"fmt"

"io/ioutil"

"net/http"

"path"

"regexp"

"strconv"

"strings"

"sync"

"time"

)

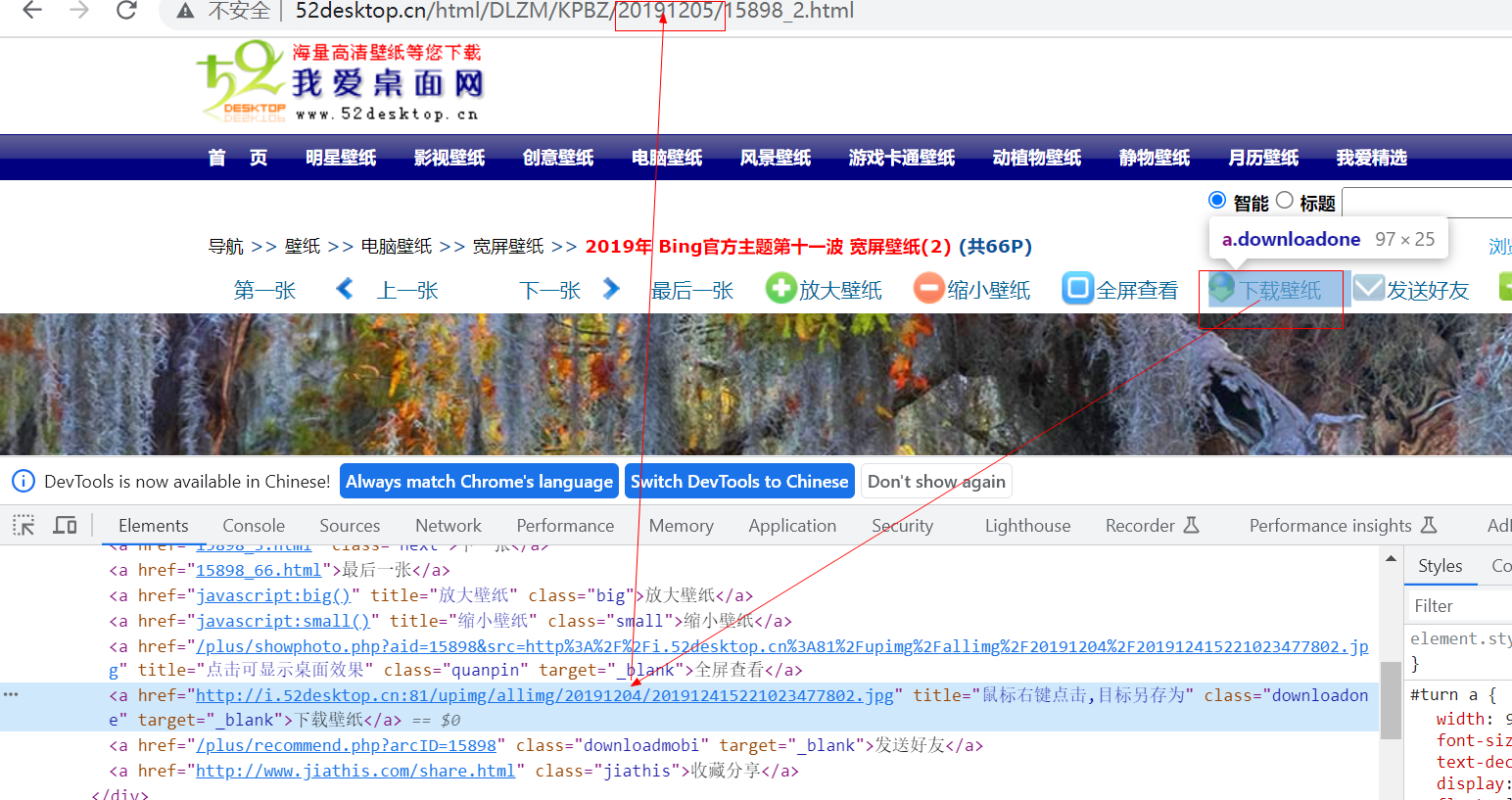

var (

geReImg = `http://i.52desktop.cn:81/upimg/allimg/[^"]+?(\.((jpg)|(png)|(jpeg)|(gif)|(bmp)))`

chanImageUrls chan string

waitGroup sync.WaitGroup

chanTask chan string

chanTaskCount = 23

count int

)

func getImgs(url string) (urls []string) {

pageStr := GetPageStr(url)

re := regexp.MustCompile(geReImg)

results := re.FindAllStringSubmatch(pageStr, -1)

fmt.Printf("共找到%d条结果\n", len(results))

for _, result := range results {

url := result[0]

if strings.Contains(result[0], "20191204") {

urls = append(urls, url)

}

}

return urls

}

func getImgUrls(url string) {

urls := getImgs(url)

for _, url := range urls {

chanImageUrls <- url

}

chanTask <- url

waitGroup.Done()

}

func CheckOk() {

for {

url := <-chanTask

fmt.Printf("%s 完成了爬虫任务\n", url)

count++

if count == chanTaskCount-2 {

close(chanImageUrls)

break

}

}

waitGroup.Done()

}

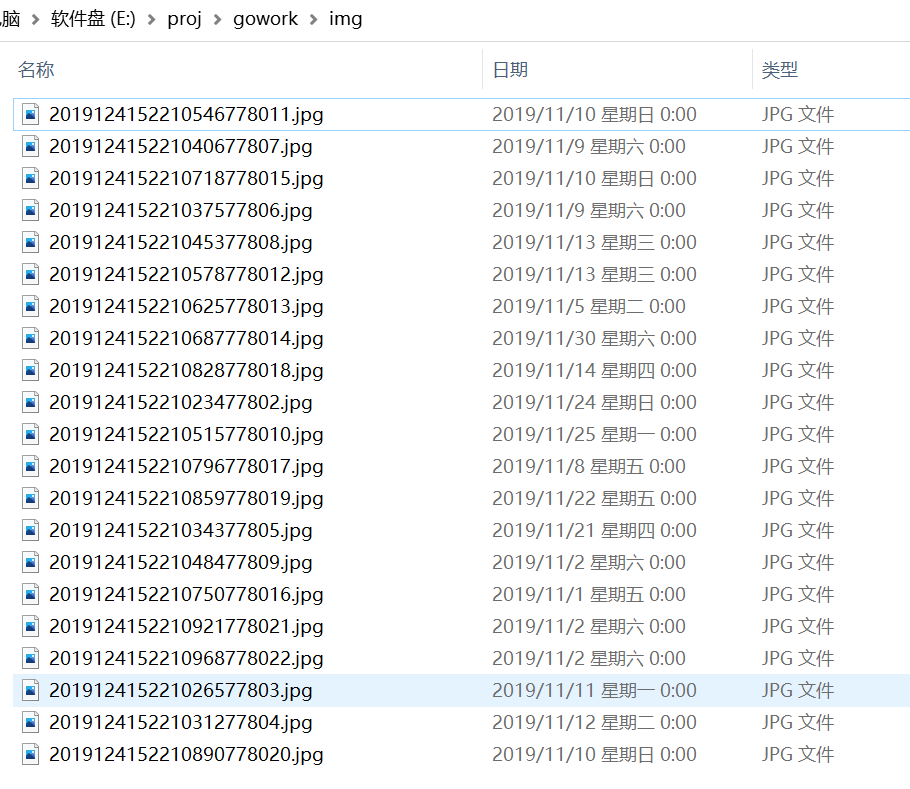

func downloadFile(savePath string, url string) {

v, err := http.Get(url)

if err != nil {

fmt.Println("http.Get error", err)

return

}

defer v.Body.Close()

fileName := savePath + path.Base(url)

bytes, err := ioutil.ReadAll(v.Body)

if err != nil {

fmt.Println("io.ReadAll error", err)

return

}

err = ioutil.WriteFile(fileName, bytes, 0666)

if err != nil {

fmt.Println("ioutil.WriteFile error", err)

return

}

fmt.Println(fileName, " download is success")

}

func DownloadImg() {

for url := range chanImageUrls {

downloadFile("E:\\proj\\gowork\\img\\", url)

}

waitGroup.Done()

}

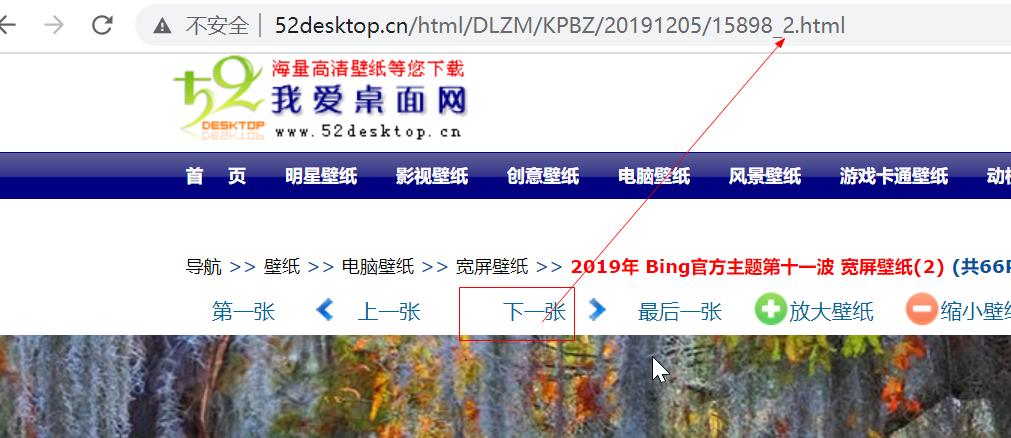

func GetCrawl2Img() {

chanImageUrls = make(chan string, 100)

chanTask = make(chan string, chanTaskCount)

start := time.Now()

for i := 2; i < chanTaskCount; i++ {

waitGroup.Add(1)

go getImgUrls("http://www.52desktop.cn/html/DLZM/KPBZ/20191205/15898_" + strconv.Itoa(i) + ".html")

}

waitGroup.Add(1)

go CheckOk()

go func() {

waitGroup.Wait()

fmt.Println("All workers have completed.")

}()

for i := 0; i < 5; i++ {

waitGroup.Add(1)

go DownloadImg()

}

waitGroup.Wait()

elapse := time.Since(start)

fmt.Println("elapsed time is : ", elapse, "s")

}

|